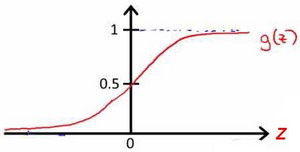

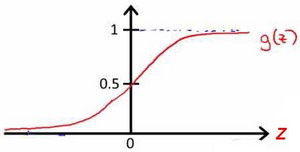

Logistics Function图像为:

函数形式为: g(z)=11+e−z。

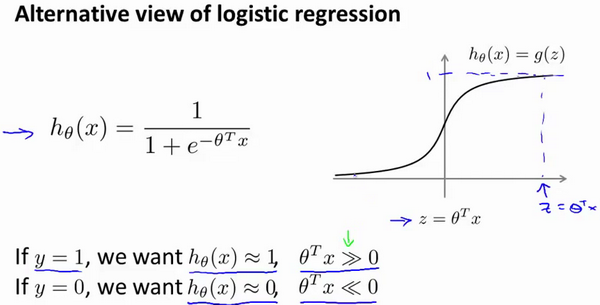

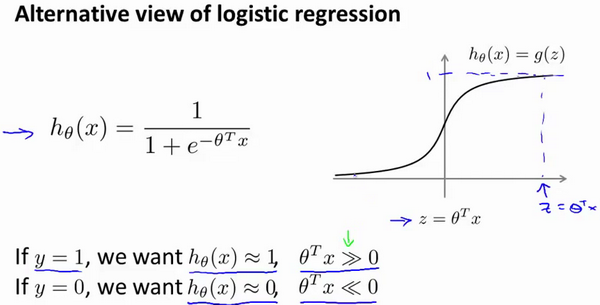

hθ(x)=g(θTx)=11+e−θTx

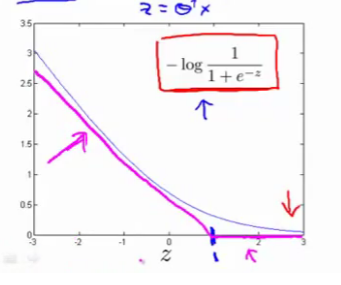

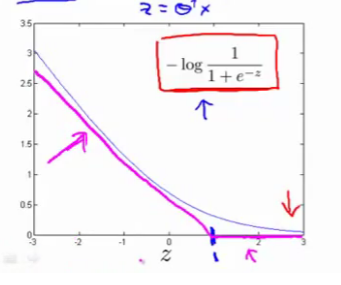

逻辑回归的代价函数为

J(θ)=1m∑mi=1cost(hθ(x(i)),y(i))

其中,

cost(hθ(x),y)={−log(hθ(x)) if y=1−log(1−hθ(x)) if y=0

自变量是hθ(x),而hθ(x)∈[0,1]

需要注意的是,逻辑回归最终输出的是判定y归类的概率,例如hθ(x)=0.7,则表示70%的概率y归为正向类,而最终y的取值是1,代价函数取−log(hθ(x))。

在逻辑回归中,我们预测:

当hθ(x)≥0.5时,预测 y=1。

当hθ(x)<0.5时,预测 y=0 。

记住hθ(x)=11+e−θTx

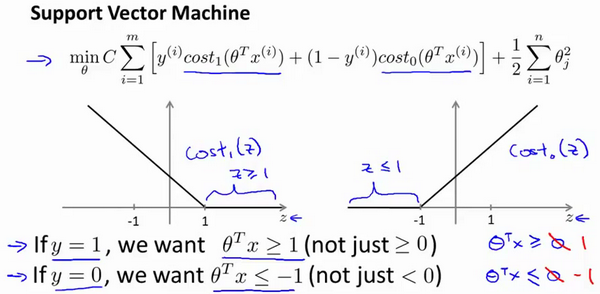

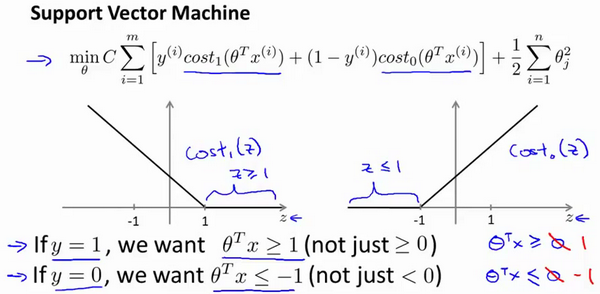

SVM的代价函数在Sigmoid函数取log之后修改而来,类似平移之后的Relu函数。

SVM被称为Large margin classifier正是归功于这个代价函数

引入kernels之后,预测方法为:给定x,计算新特征f(即kernel),当θTf≥0 时,预测 y=1,否则反之。

最后,一言以蔽之:we use features f(i) instead of the original x(i).